tmb

Mitglieder-

Gesamte Inhalte

18 -

Benutzer seit

-

Letzter Besuch

Inhaltstyp

Profile

Forum

Downloads

Kalender

Blogs

Shop

Alle Inhalte von tmb

-

Cool. Danke Dir! Ja, ich werde die Umstellung Nachts vornehmen, und die Weiterleitung der alten IP auch. Sodass kein Ausfall passieren kann. Vielen Dank für Eure Antworten!

-

nichts. also nur als Ergänzung, aber wahrscheinlich ist es wirklich nicht notwendig! Danke Dir!

-

Hi, das habe ich mir schon fast gedacht. Wäre es denn sinnvoll, dass ich die alte IP noch etwas behalte und einen redirect auf die neue mache? Es linken ja unwahrscheinlich viele Websites (whois seiten, etc.) auf die Doman mit der alten ip - oder ist das komplett egal?

-

Hallo, ich habe eine Frage. Ich würde gerne von einem vServer zu einem RootServer und zusätzlich neuem Anbieter wechseln. Meine Domain habe ich via A-Record auf den vServer weitergeleitet. Der Server diente nicht als E-Mail Server. Wäre es möglich bzw. sinnvoll die IP auf den anderen Server zu übertragen? Das ist eine sehr allgemeine Frage oder tut das nichts zu Sache (SEO, Robots, ...). Vielen Dank. Gruß Michael

-

Update. Also ich habe die Fehlerquelle gefunden. Es war ein defekter WLAN Router. Nach dem Booten hat er komplett das Netzwerk blockiert und dauerhaft Pakete an alle Clients geschickt. Router ausgetauscht und alles läuft wieder. Vielen Dank!!!!

-

Vielen Dank für die ausführliche Antwort!!! - VPN ist derzeit aktiviert, wird aber nur selten genutzt. Bringt es was den dynamischen Addressraum zu verringern - da alles Clients feste IP Adressen im Netzwerk haben, benötigen wir ja auch nur ein paar "dynamische" Adressräume für die WLAN Geräte? - Eigentlich sollte die Anbindung auf 1GBIT/s laufen, ich überprüfe aber nocheinmal das ganz - gute Idee- vielleicht auch ein falsches Kabel... - Die Anschlüsse sind auch automatisch im Switch gestellt, da nicht alle Clienst 1GBIT/s können, dachte ich wäre das die einfachste Methode - macht es Sinn dieses manuell für jeden Client einzustellen? - Software teste ich auch mal! - Der Xerox Drucker schickt dauerhaft Pakete an alle Clients. - Ich habe als erste im Switch Storm Control und Auto DoS aktiviert. Ich werde weiter Eingrenzen und schreiben, wenn ich was hab. VIELEN DANK!

-

Du meinste mit wireshark einmal mitzuhören - worauf soll ich achten? Kannst du ein paar tipps geben? Danke Dir!

-

Hallo, ich habe ein Netzwerk von etwa 20 Clients (Windows 7, XP Home + Prof, Mac OS X, Ubuntu). Dadrunter sind auch 3 Netzwerkdrucker. Das ganze läuft über einen HP 1810-24G Switch mit 1.000 Mbit, als Router dient ein Bintec R3002. Das WLAN geht über ein altes Speedport. Der Bintec dient dabei als DNS. Vorzugsweise haben alle festen Geräte eine feste IP- Nun zu den Problemen. 1. in unregelmäßigen Abständen ist es nicht möglich zu drucken. Die Drucker sind stellenweise nicht erreichbar unter Windows. Am nächsten Tag funktioniert es dann wieder. 2. Die Verbindung ist internet auch sehr schlecht, manchmal sind selbst Verbindungen über 1Gbit und Subversion sehr langsam - was eigentlich nicht sein dürfte. Gibt es eine Möglichkeit, dass ein Gerät im Netzwerk defekt ist und Datenpackete im hohen Maße verschickt? Wie suche ich am besten nach der Fehlerquelle? Gruß Torben

-

OK - habe ich überlesen. Was genau meinst du mit Internetanschluss? Devices LAN / WLAN?

-

Ja. Bei Safari und Chrome - aber nur immer mal wieder... Manchmal geht es weg, wenn ich den Browser komplett schließe... Manchmal nicht...

-

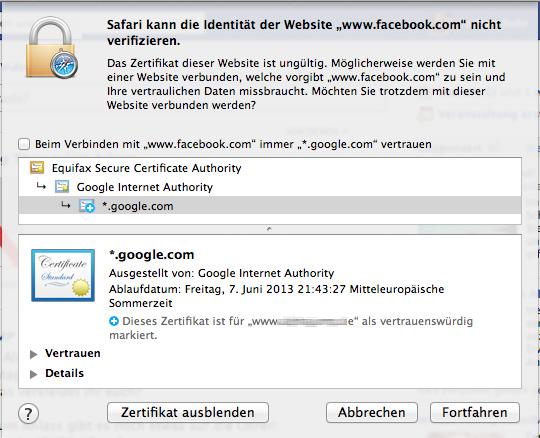

Das hier zum Beispiel: Ich gehe auf facebook.com dann fragt er mich, ob ich google.com immer vertrauen will und unten steht dann eine andere Domain... Ich versteh das nicht!

-

Hallo, seit der Umstellung auf einen neuen Router (Bintec R3002) habe ich unter Mac OS X starke Probleme bei verschiedenen Seiten. Wenn ich z.B. Facebook.com aufrufe, kommt in unregelmäßiges Abständen ein Zertifikatsproblem von *.google.com, dem ich mit Administratorrechten zustimmen muss. Das ganze ist bei diversen Seiten der Fall, beim Safari und chrome. Beim chrome kommt dann oft der rote Hinweis, dann ein google 503 Error. Kann das am Router liegen? Manche Seiten werden auch einfach leer dargestellt. Wir sind derzeit etwa 20 PCs im Netzwerk, bis jetzt haben nur die Mac OSX COmputer Probleme, Windows und Ubuntu laufen problemlos! Vielen Danke für Eure Hilfe! Torben

-

ja, Aktualität ist das Problem. Ich weiß nicht, ob ich mich richtig ausgedrückt habe @flashpixx. Ich wollte nicht das Ergebnis speichern, sondern nur die geolocations, die ich von googe bekomme. Geolocation API - Gears API - Google Code Somit habe ich irgendwann eine Basis von Städten und Adressen, die immer wieder auftreten und den Umkreis kann ich ja mit der oberen Formel berechnen, somit dachte ich, erhalte ich eine schnelle Lösung, die auch mit wenigen WebService abfragen funktioniert.

-

Alles klar. @Pixie: Fast. Ich dachte halt, wenn ich nach "Berlin" suche, frage ich einmalig googeMaps nach den Koordinaten ab, speicher Sie dann in einer Tablelle z.B. locations, mit allen googlemaps Daten. Jetzt kann ich ja mit folgender Formel: In meinen anderen Tabellen suchen. Sucht nun eine weitere Person nach "Berlin", entnehme ich die Daten aus meiner Datenbank. Klingt für mich nun auch sehr kompliziert - die Frage ist halt, obs sinnvoll und performant läuft, ich habe gut 1.2 mio Ortsangaben mit PLZ in verschiedenen Tabellen, deshalb die Umstrukturierung.

-

ja,bei einer internen suche - um ziele einzugrenzen. Jeder User kann auf diese Suche zugreifen.

-

Um die Anzahl der Abfragen auf dauer zu minimieren. google setzt bei großer Abfrage ein limit und danach wird die Nutzung sehr teuer. Die Daten von OpenGeoDb sind ja relativ gut aufbereitet! Zumal wenn ich nur auf googleMaps aufbaue, muss ich die Daten ja auch irgendwie speichern. Was schlägst du dort vor? Also der User gibt praktisch den Namen seiner Stadt ein, ggf. mit PLZ. Dann gibt mir googleMaps API die Längen- und Breitengrade zurück - diese speicher ich dann?

-

Hallo, ich habe eine Frage zu einer, wie ich finde, komplexen Problemkonstellation. Sicher ist dieses Thema bereits mehrfach im Internet zu finden, jedoch würde ich gerne Eure persönliche Meinung zu diesem Thema wissen: Es gibt ca. 30 MySQL Tabellen in meinem Projekt, die Ortsangaben enthalten. Ich habe zuerst den Namen als varchar in den einzelnen Tabellen hinzugefügt. Nun soll jedoch eine Umkreissuche verwendet werden, welches ein Problem bei mehrfach Ortsnamen aufwirft. Also habe ich mir gedacht, die Zeilen der Ortsangabe als Tabelle mit Postleitzahl und Längen und Breitengrad als eigene Tabelle auszulagern und den Ort dann als ForeignKey zu setzen. Nach der Recherche zu googleMaps und OpenGeoDb ist mir dann aufgefallen, dass ich viele Daten bereich als dumP erhalte, und somit doppelanfragne zu googlemaps verhindern kann, wenn diese bereits in meiner DB liegen. In Hinblick auf internationale Orte, stellt dieses aber ein großes Problem dar - die Tabelle wird riesig und Wartung und Aktualisierung werden sehr komplex. Was wäre eure Intention zu diesem Problem? Wir machen dieses andere Großprojekte? Vielen Dank für Eure Tipps und Anregungen!!!!

-

Hallo, ich habe eine Frage, bzw. mich würden Eure Erfahrungen interessieren. Folgendes soll erstellt werden: Eine Art "Social-Community", jeder Benutzer kann verschiedene personenbezogene Daten eingeben, welche jeweils in verschiedenen Tabellen liegen. z.B. Termine, Interessen, Adressen... Nun soll er für verschiedene andere Nutzer "Zugangriffe" einrichten können, einmal allgemein z.B. für Freunde, Unbekannte. Und er soll für einzelne Leute direkte Rechte festlegen können, z.B. Freund A darf nur Events sehen, Freund B alles. Wie würdet Ihr dieses logischerweise in die Datenbank packen? Das System würde ich gerne als Ruby on Rails 3 Projekt programmieren. In Hinsicht auf Performanz und Skalierung suche ich eine sehr gute Lösung. Da Joins auf mehrere Tabellen bei vielen Zugriffen sehr "teuer" sind, würde ich das ganze gerne Cachen, sodass die einzelnen Zugriffsrechte feststehen. Ich danke für Eure Hilfe! TMB